Dans la catégorie des critiques sur la recherche scientifique, la méthodologie, le processus de publication… voici un article de Regina Nuzzo, chargée de cours en statistiques à l’Université Gallaudet de Washington DC, qui traite de l’utilisation abusive des p-values.

Article original: « Scientific method: Statistical errors » publié le 12 février 2014 sur Nature.

Pendant un bref instant en 2010, Matt Motyl était à deux doigts d’une gloire scientifique: il avait découvert que les extrémistes voient littéralement le monde en noir et blanc.

Les résultats étaient clairs comme de l’eau de roche, se rappelle Motyl, un thésard en psychologie à l’Université de Virginia à Charlottesville. Les données d’une étude portant sur près de 2000 personnes montraient que les personnes politiquement modérées voyaient les nuances de gris avec plus d’acuité que les extrémistes de gauche ou de droite. « L’hypothèse était sexy, dit-il, et les données la soutenaient clairement. » La p-value, une valeur courante pour représenter la robustesse d’un résultat, était de 0.01 – habituellement interprété comme un résultat très significatif. La publication dans un journal à haut impact était à portée de main pour Motyl.

Puis intervint la réalité. Attentifs aux controverses à propos de la reproductibilité, Motyl et son conseiller, Brian Nosek, décidèrent de répliquer l’étude. Avec des données supplémentaires, la p-value est remontée à 0.59 – bien loin de la valeur conventionnelle de significativité, 0.05. L’effet avait disparu, et avec lui, les rêves de gloire précoce de Motyl1.

Le problème ne se trouvait ni dans les données ni dans les analyses de Motyl. Il se trouvait dans la nature étonnamment versatile de la p-value, qui n’est pas aussi fiable ou objective que les scientifiques pensent. « Les p-values ne font pas leur boulot, parce que ce n’est pas le leur, » dit Stephen Ziliak, un économiste à l’Université Roosevelt de Chicago, Illinois, et un critique régulier de la façon dont les statistiques sont utilisées.

Pour de nombreux scientifiques, c’est un sujet préoccupant, surtout par rapport aux inquiétudes sur la reproductibilité. En 2005, l’épidémiologiste John Ioannidis de l’Université Stanford en Californie avait suggéré que la plupart des résultats publiés étaient faux2; depuis lors, une série de problèmes de réplication très médiatisés ont obligé les scientifiques à repenser leur façon d’évaluer des résultats.

Parallèlement, les statisticiens cherchent de meilleures manières de penser les données, afin d’aider les scientifiques à ne pas manquer d’informations importantes ou à prendre des décisions sur base de fausses alarmes. « Changez votre philosophie statistique et tout à coup d’autres choses deviennent importantes », dit Steven Goodman, médecin et statisticien à Stanford. « Alors, les ‘lois’ descendues de Dieu ne sont désormais plus descendues de Dieu. Elles nous sont en réalité remises par nous-mêmes, à travers la méthodologie que nous adoptons. »

Hors contexte

Les p-values ont toujours fait l’objet de critiques. Pendant leur existence de près de neuf décennies, elles ont été comparées aux moustiques (ennuyants et impossible à s’en débarrasser), aux habits neufs de l’empereur (truffés de problèmes évidents que tout le monde ignore) et à un outil de « labourage intellectuel stérile » qui ravit la science mais la laisse sans progéniture3. Un chercheur a suggéré de rebaptiser la méthodologie « Statistical Hypothesis Inference Testing »3, sans doute pour l’acronyme que ça donnerait. [NdT: « shit » signifie « merde » en anglais]

Ironiquement, lorsque le statisticien britannique Ronald Fisher introduisit la p-value dans les années 1920, il ne voulait pas en faire un test définitif. Son but était simplement d’avoir un moyen informel de juger si des preuves étaient significatives, au sens plus ancien: qui méritent d’être approfondies. L’idée était de faire une expérience, puis regarder si les résultats étaient cohérents avec ce que le hasard seul aurait produit. Les chercheurs établiraient en premier lieu une « hypothèse nulle » qu’ils voudraient réfuter, par exemple l’absence de corrélation ou aucune différence entre deux groupes. Ensuite, ils se feraient l’avocat du diable et, considérant que l’hypothèse nulle est en fait vraie, calculeraient la probabilité d’obtenir des résultats au moins aussi extrêmes que ce qui a réellement été observé. Cette probabilité est la p-value. Plus elle est petite, suggérait Fisher, plus grandes étaient les chances que l’hypothèse nulle soit fausse.

La p-value a beau sembler être d’une grande précision, Fisher voulait simplement en faire une partie d’un processus fluide, non numérique, qui mêlait données et connaissances de base pour arriver à une conclusion scientifique. Mais son idée fut bientôt balayée par un autre mouvement qui voulait rendre la prise de décision basée sur les preuves aussi rigoureuse et objective que possible. Ce mouvement a été lancé dans la fin des années 1920 par les rivaux acerbes de Fisher, le mathématicien polonais Jerzy Neyman et le statisticien britannique Egon Pearson, qui introduisirent un nouveau cadre pour l’analyse des données comprenant puissance statistique, faux positifs, faux négatifs, et de nombreux autres concepts désormais familiers pour quiconque a suivi des cours de statistiques de base. Ils ont expressément laissé la p-value de côté.

Mais alors que les rivaux s’affrontaient – Neyman a qualifié certains travaux de Fisher de mathématiquement « pires qu’inutiles »; Fischer a qualifié l’approche de Neyman « d’enfantine » et de « terrifiante pour la liberté intellectuelle occidentale » – d’autres chercheurs perdirent patience et se mirent à écrire des manuels de statistiques pour les scientifiques. Et comme nombre de leurs auteurs n’étaient pas statisticiens et manquaient d’une compréhension approfondie des deux approches, ils ont créé un système hybride qui forçait la p-value de Fisher, facile à calculer, à rentrer dans le système régulé et rigoureux de Neyman et Pearson. C’est alors qu’une p-value de 0.05 devenait « statistiquement significative », par exemple. « La p-value n’a jamais été pensée pour être utilisée de la façon dont elle est aujourd’hui utilisée », dit Goodman.

Qu’est-ce que ça signifie?

Résultat: beaucoup de confusion sur ce que signifie la p-value4. Prenez l’étude de Motyl à propos des extrémistes politiques. La plupart des scientifiques regarderaient sa première p-value et diraient qu’il y a simplement 1% de chance que son résultat soit une fausse alarme. Mais ils auraient tort. La p-value ne permet pas de dire ça: tout ce qu’elle peut faire, c’est résumer les données en considérant vraie une hypothèse nulle spécifique. Elle ne peut pas fonctionner à l’envers et mettre en avant des affirmations sur la réalité sous-jacente. L’ignorer serait semblable à se réveiller avec un mal de tête et conclure qu’on a une tumeur rare au cerveau – possible, mais tellement improbable que cela requiert beaucoup plus de preuves pour supplanter une explication plus prosaïque comme une réaction allergique. Moins l’hypothèse est plausible – télépathie, extra-terrestres, homéopathie – plus grandes sont les chances qu’un résultat excitant soit une fausse alarme, peu importe la valeur de la p-value.

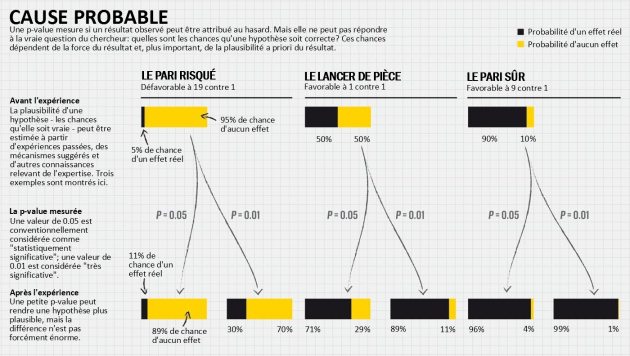

Ce sont des concepts ardus, mais certains statisticiens ont essayé de fournir des règles de conversion générales (voir Cause probable). Selon un calcul souvent utilisé5, une p-value de 0.01 correspond à une probabilité de faux positif de 11%, dépendant la probabilité sous-jacente qu’il y ait un vrai effet; une p-value de 0.05 augmente cette probabilité à au moins 29%. Le résultat de Motyl avait donc plus d’une chance sur dix d’être un faux positif. Pareillement, la probabilité de réplication de son résultat original n’était pas 99%, comme beaucoup pourraient le penser, mais quelque chose plus proche de 73% – ou même seulement 50%, s’il voulait un autre résultat « très significatif »6, 7. Autrement dit, le fait de n’avoir pu répliquer ses résultats était aussi surprenant que prédire pile à un lancer de pièce et tomber sur face.

Les critiques déplorent également la façon dont les p-values peuvent encourager la confusion dans le raisonnement. Un exemple flagrant est leur tendance à détourner l’attention de la force réelle d’un effet. L’année passée, par exemple,une étude de plus de 19 000 personnes a montré8 que ceux qui rencontrent leur époux(se) en ligne ont moins de risques de divorce (p < 0.002) et plus de chances d’être heureux dans sa vie de marié(e) (p < 0.001) que ceux qui se sont rencontrés hors ligne (voir Nature http://doi.org/rcg; 2013). Cela peut sembler impressionnant, mais les effets étaient en réalité très petits: se rencontrer en ligne faisait descendre le taux de divorce de 7.67% à 5.96%, et faisait monter le niveau de bonheur de 5.48 à seulement 5.64 sur une échelle de 7. Bondir sur les minuscules p-values et ignorer le reste de la problématique, c’est être victime de la « séduisante certitude de significativité », dit Geoff Cumming, psychologue émérite à l’Université La Trobe à Melbourne, Australie. Mais la significativité n’est pas un indicateur de pertinence pragmatique, dit-il: « Nous devrions surtout nous demander “Quelle est la taille de l’effet?” plutôt que “Y a-t-il un effet?” »

Sans doute la pire erreur dans tout ça est la tendance à se duper soi-même, pour laquelle le psychologue Uri Simonsohn de l’université de Pennsylvanie et ses collègues ont popularisé le terme p-hacking. « Le p-hacking, dit Simonsohn, est le fait d’essayer plein de tests jusqu’à tomber sur le résultat voulu » – même inconsciemment. C’est peut-être le premier terme statistique à avoir une entrée dans l’Urban Dictionary, où on peut voir les exemples suivants: « Ce résultat semble avoir été obtenu par du p-hacking, les auteurs ont omis des conditions pour que la p-value totale soit inférieure à .05 », et « C’est une p-hackeuse, elle est toujours en train de surveiller les données en train d’être collectées. »

De telles pratiques ont comme effet de transformer des découvertes issues de travaux exploratoires – qui devraient être considérés avec scepticisme – en quelque chose qui ressemble à des confirmations solides, mais qui disparaissent lors de réplications. Les simulations de Simonsohn ont montré9 que des modifications de quelques décisions à propos de l’analyse des données peuvent augmenter le taux de faux positif de 60% dans une seule étude. Le p-hacking est particulièrement présent, dit-il, dans l’environnement actuel d’études qui font la chasse aux petits effets dissimulés dans des données fortement bruitées. Il est difficile d’évaluer à quel point ce problème est répandu, mais Simonsohn a le sentiment qu’il est très présent. Dans une analyse10, il a trouvé des preuves que de nombreux articles publiés en psychologie rapportent des p-values qui forment des agrégats suspects autour de 0.05, exactement ce à quoi on s’attendrait si des chercheurs faisaient la pêche aux p-values significatives jusqu’à en trouver.

Un jeu de chiffres

Malgré les critiques, la réforme a été lente. « Le cadre de base des statistiques est resté inchangé depuis que Fisher, Neyman et Pearson l’ont introduit », dit Goodman. John Campbell, un psychologue à l’Université de Minnesota à Minneapolis, a déploré le problème en 1982, lorsqu’il était éditeur au Journal of Applied Psychology. « C’est quasiment impossible d’arracher les auteurs à leurs p-values, et plus il y a de zéros après la virgule, plus les gens s’y accrochent. »11 En 1989, lorsque Kenneth Rothman de l’Université de Boston au Massachusetts lança le journal Epidemiology, il fit de son mieux pour éviter les p-values dans ses pages. Mais il a quitté le journal en 2001, et depuis, les p-values ont fait leur retour.

Ioannidis est en train de creuser la base de données PubMed afin de mieux comprendre comment les auteurs dans divers domaines utilisent les p-values avec d’autres données statistiques. « Un examen rapide d’une série de papiers récemment publiés, dit-il, montre clairement que les p-values sont encore très, très populaires. »

Une réforme serait nécessaire pour balayer une culture fermement établie. Elle devrait changer la façon dont les statistiques sont enseignées, dont les analyses de données sont faites et dont les résultats sont rapportés et interprétés. Mais au moins, les chercheurs reconnaissent qu’il y a un problème, explique Goodman. « La sonnette d’alarme, c’est que de nombreux résultats publiés sont faux. » Les travaux de chercheurs comme Ioannidis mettent en évidence le lien entre les difficultés statistiques théoriques et les problèmes réellement rencontrés, dit Goodman. « Les problèmes prédits par les statisticiens sont exactement ceux que l’on observe aujourd’hui. Mais nous n’avons pas encore les solutions. »

Les statisticiens ont proposé une série de mesures pour y parvenir. Afin d’éviter le piège de penser les résultats en termes de significativité, par exemple, Cumming pense que les chercheurs devraient systématiquement rapporter la taille de l’effet et les intervalles de confiance. Ces derniers offrent une information que la p-value n’a pas: l’importance relative d’un effet.

Beaucoup de statisticiens prônent le remplacement de la p-value avec des méthodes qui tirent profit du théorème de Bayes: un théorème du 18e siècle qui décrit une façon de penser les probabilités comme la plausibilité d’un résultat, plutôt que la fréquence potentielle de ce résultat. Cela suppose une certaine subjectivité – quelque chose que les pionniers des statistiques avaient essayé d’éviter. Mais le cadre bayésien rend la tâche de l’observateur plus facile, par comparaison, pour incorporer leurs connaissances a priori dans leurs conclusions, et pour calculer comment les probabilités sont modifiées par des preuves nouvellement acquises.

D’autres préconisent une approche plus large et encouragent les chercheurs à essayer plusieurs méthodes sur leurs données. Stephen Senn, statisticien au Centre de Recherche pour la Santé Publique à Luxembourg, compare ceci à un robot aspirateur qui n’arrive pas à se dégager d’un coin: n’importe quelle méthode d’analyse de données atteindra un moment un cul-de-sac, et un peu de bon sens sera nécessaire pour relancer le processus. Si les diverses méthodes fournissent des réponses différentes, dit-il, « cela suggère d’être plus créatif pour tenter de comprendre pourquoi », ce qui devrait aboutir à une meilleure compréhension de la réalité sous-jacente.

Simonsohn affirme qu’une des meilleures protections pour les scientifiques est de tout reconnaître. Il encourage les auteurs à marquer leurs articles « p-certifié, sans p-hacking » en incluant les mots suivants: « Nous rapportons notre méthode pour déterminer la taille de l’échantillon, toute exclusion de données (le cas échéant), toutes les manipulations et toutes les mesures dans cette étude. » Cette transparence, espère-t-il, découragera la pratique du p-hacking, ou du moins alertera les lecteurs de potentielles entourloupes et leur permettra un jugement plus éclairé.

Une autre idée qui commence à se faire connaître est l’analyse en deux étapes, ou « réplication pré-registrée », explique Andrew Gelman, scientifique politique et statisticien à l’Université de Columbia à New York City. Selon cette approche, des analyses exploratoires et confirmatoires sont abordées différemment et clairement identifiées. Au lieu de faire quatre petites études séparément et de rapporter les résultats dans un seul article, par exemple, les chercheurs feraient d’abord deux petites études exploratoires et rassembleraient les résultats potentiellement intéressants sans trop se préoccuper des fausses alarmes. Ensuite, sur base de ces résultats, les auteurs décideraient précisément comment ils comptent confirmer leurs résultats, et pré-enregistreraient publiquement leurs intentions dans une base de données comme l’Open Science Framework (https://osf.io). Ils s’attaqueraient alors aux études de réplication et publieraient les résultats avec ceux des études exploratoires. Cette approche permet une certaine liberté et une flexibilité dans les analyses, dit Gelman, tout en procurant suffisamment de rigueur afin de réduire le nombre de faux positifs publiés.

Plus généralement, les chercheurs doivent prendre conscience des limites des statistiques conventionnelles. Ils devraient plutôt apporter à leurs analyses des éléments de jugement scientifique sur la plausibilité d’une hypothèse et les limitations de l’étude qui sont habituellement confinées dans la section discussion: résultats d’autres expériences identiques ou similaires, mécanismes proposés, connaissances cliniques, etc. Le statisticien Richard Royal de la Johns Hopkins Bloomberg School of Public Health à Baltimore, Maryland, a dit qu’il y avait trois questions auxquelles un scientifique devrait penser après une étude: « Quelles sont les preuves? », « Que devrais-je croire? » et « Que devrais-je faire? » Une méthode unique ne peut répondre à toutes ces questions, dit Goodman: « Les chiffres devraient être le commencement d’une discussion, non l’aboutissment; »

Nature 506, 150–152 (13 February 2014) | doi:10.1038/506150a

Références

1. Nosek, B. A., Spies, J. R. & Motyl, M. Perspect. Psychol. Sci. 7, 615–631 (2012). Article ↵

2. Ioannidis, J. P. A. PLoS Med. 2, e124 (2005). Article Pubmed ↵

3. Lambdin, C. Theory Psychol. 22, 67–90 (2012). Article ↵

4. Goodman, S. N. Ann. Internal Med. 130, 995–1004 (1999). Article ISI ChemPort ↵

5. Goodman, S. N. Epidemiology 12, 295–297 (2001). Article PubMed ISI ChemPort ↵

6. Goodman, S. N. Stat. Med. 11, 875–879 (1992). Article PubMed ISI ChemPort ↵

7. Gorroochurn, P., Hodge, S. E., Heiman, G. A., Durner, M. & Greenberg, D. A. Genet. Med. 9, 325–321 (2007). Article PubMed ISI ↵

8. Cacioppo, J. T., Cacioppo, S., Gonzagab, G. C., Ogburn, E. L. & VanderWeele, T. J. Proc. Natl Acad. Sci. USA 110, 10135–10140 (2013). Article PubMed ChemPort ↵

9. Simmons, J. P., Nelson, L. D. & Simonsohn, U. Psychol. Sci. 22, 1359–1366 (2011). Article PubMed ↵

10. Simonsohn, U., Nelson, L. D. & Simmons, J. P. J. Exp. Psychol. http://dx.doi.org/10.1037/a0033242 (2013). ↵

11. Campbell, J. P. J. Appl. Psych. 67, 691–700 (1982). Article ↵

Merci pour cette traduction. Trop peu d’article explicitent clairement ce qu’est la p-value. Et dans la pratique entre ce que les gens croient comprendre ce qu’elle est et ce qu’il en font on arrive a un nombre affolant de fausses interpretations.

J’aimeAimé par 1 personne